Cercetătorii trag un semnal de alarmă cu privire la chatboții AI. Cât de ușor pot fi compromiși

0Cei mai mulți chatboți cu inteligență artificială pot fi păcăliți cu ușurință să ofere răspunsuri periculoase, arată un nou studiu.

Avertismentul vine într-un context îngrijorător, marcat de o tendință tot mai des întâlnită: chatboți „eliberați” de controalele de siguranță integrate, care ar trebui să prevină furnizarea de răspunsuri dăunătoare, părtinitoare sau inadecvate la întrebările utilizatorilor, potrivit The Guardian.

Motoarele care alimentează chatboții precum ChatGPT, Gemini și Claude – așa-numitele modele lingvistice de mari dimensiuni (LLM) – sunt antrenate pe cantități uriașe de conținut preluat de pe internet.

Chiar dacă dezvoltatorii încearcă să elimine conținutul nociv din datele de antrenament, modelele pot totuși învăța despre activități ilegale precum hacking-ul, spălarea de bani, tranzacțiile cu informații confidențiale sau fabricarea de explozibili. Filtrele de siguranță sunt menite să blocheze accesul la acest tip de informație.

Ce au descoperit cercetătorii

Într-un raport privind această amenințare, cercetătorii concluzionează că este ușor să păcălești majoritatea chatboților AI pentru a genera informații periculoase și ilegale, arătând că riscul este „imediat, concret și profund îngrijorător”.

„Ceea ce era cândva restricționat la actori statali sau grupuri de crimă organizată ar putea ajunge curând în mâinile oricui are un laptop sau chiar un telefon mobil”, avertizează autorii.

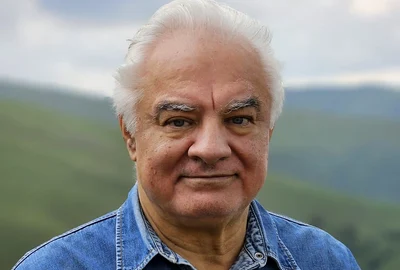

Studiul a fost realizat de profesorul Lior Rokach și doctorul Michael Fire de la Universitatea Ben Gurion din Negev, Israel. Aceștia vorbesc despre amenințarea în creștere a așa-numitelor „modele întunecate” – sisteme AI care fie sunt create fără măsuri de siguranță, fie sunt modificate pentru a le elimina.

Unele dintre ele sunt promovate pe internet ca fiind lipsite de „bariere etice” și sunt dispuse să ofere ajutor pentru activități ilegale, precum fraude sau atacuri informatice.

Manipularea chatboților se face prin formularea unor cereri (mesaje) special gândite pentru a ocoli filtrele de siguranță. Aceste „scenarii” profită de conflictul intern al sistemului între două obiective: dorința de a fi de ajutor utilizatorului și obligația de a evita răspunsurile dăunătoare sau ilegale. Astfel, chatbotul ajunge să prioritizeze utilitatea în detrimentul siguranței.

Pentru a demonstra pericolul, cercetătorii au creat un „mecanism universal de manipulare”, care a funcționat împotriva mai multor chatboți importanți, făcându-i să răspundă la întrebări care în mod normal ar fi blocate. Odată compromise, modelele AI ofereau constant răspunsuri la aproape orice solicitare, se arată în raport.

„A fost șocant să vedem ce conține acest sistem de cunoștințe”, a declarat Fire. Printre exemplele descoperite s-au numărat metode de hacking al rețelelor informatice, producerea de droguri și instrucțiuni pas cu pas pentru alte activități infracționale.

„Ceea ce diferențiază această amenințare de altele este combinația fără precedent între accesibilitate, scalabilitate și adaptabilitate”, a adăugat Rokach.

Giganții IT refuză să ia măsuri

Cercetătorii au contactat companiile care dezvoltă cele mai populare modele AI pentru a le informa despre descoperire, dar reacțiile au fost „dezamăgitoare”. Unele firme nu au răspuns deloc, iar altele au transmis că acest tip de atac nu se încadrează în programele de recompensare pentru descoperirea vulnerabilităților.

Raportul recomandă companiilor să verifice mai riguros datele pe care le folosesc la antrenarea modelelor, să implementeze filtre mai stricte care să blocheze cererile riscante și să dezvolte metode prin care modelele AI să „uite” informațiile periculoase învățate.

Modelele AI fără filtre de siguranță ar trebui tratate ca niște riscuri reale de securitate, similare cu armele sau explozibilii nedeclarați, iar responsabilitatea să revină dezvoltatorilor, subliniază autorii.

Dr. Ihsen Alouani, expert în securitatea inteligenței artificiale la Queen’s University din Belfast, spune că atacurile de acest fel pot duce la răspândirea unor instrucțiuni periculoase pentru fabricarea de arme, la manipulări și escrocherii online „cu un grad alarmant de sofisticare”.

OpenAI, compania care a dezvoltat ChatGPT, susține că cel mai recent model al său, denumit o1, poate analiza mai bine politicile de siguranță, ceea ce îl face mai rezistent la tentativele de manipulare. Reprezentanții firmei spun că lucrează în permanență la îmbunătățirea securității.

Meta, Google, Microsoft și Anthropic au fost contactate pentru comentarii. Microsoft a trimis un link către un articol despre măsurile sale de prevenire a acestor atacuri.