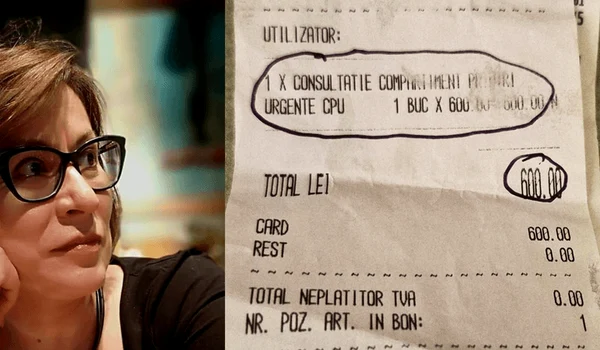

AI excelează la olimpiade de matematică, dar se împiedică la calcule simple

0Modelele de inteligență artificială pot depăși oamenii la Olimpiada Internațională de Matematică, însă uneori greșesc la operații aritmetice de nivel primar, avertizează James Fergusson, profesorul James Fergusson, specializat în cosmologie teoretică în cadrul Universității Cambridge și director al Infosys-Cambridge AI Centre, într-un articol publicat în Financial Times.

Fergusson observă că AI-ul rezolvă rapid probleme dificile asemănătoare cu cele întâlnite în seturile de antrenament, dar se blochează când trebuie să abordeze situații complet noi, în special în matematica teoretică, unde exemplele sunt rare. „Un matematician bun rezolvă probleme dificile, unul mare găsește modalități de a le face ușoare”, subliniază acesta.

Limitele apar din natura rețelelor neuronale, eficiente la interpolare, dar slabe la extrapolare. În cosmologie și matematică aplicată, AI-ul poate automatiza metode deja cunoscute, însă progresele reale în calcul rămân modeste. „Întrebarea este cât de puternic poate fi un matematician extrem de rapid, extrem de bine antrenat, dar lipsit de gândire proprie. Suntem în proces de a afla”, spune James Fergusson.

AI-ul e impresionant, dar nu e magic

„Inteligența artificială e impresionantă, dar nu magică, e modelată pentru scopuri specifice”, declară, pentru Adevărul, Nicoleta Danis, Strategic Partnerships & Marketing Manager la Devhd.

Potrivit acesteia, modelele de inteligență artificială pot fi extrem de eficiente, dar doar în limitele pentru care au fost antrenate. „Modelele LLM (Large Language Models), cum sunt cele din ChatGPT, Copilot sau NowAssist din ServiceNow, sunt construite diferit, în funcție de scopul pentru care au fost modelate. Cele generaliste, cum e ChatGPT, pot răspunde la o gamă largă de întrebări, de la matematică la literatură, dar chiar și ele pot greși în funcție de cum e formulată întrebarea sau de lipsa unui context clar. În schimb, în ServiceNow, LLM-ul este domain-specific: antrenat pentru a răspunde eficient în contexte precise, cum ar fi IT Service Management, HR Service Delivery sau Customer Service. Dacă întrebi NowAssist despre incidente IT sau procese HR, va răspunde corect, pentru că exact pentru asta a fost construit. Dar dacă îl întrebi cum e vremea, va greși – nu pentru că e «slab», ci pentru că nu are acces la acel tip de informație și nici nu a fost modelat pentru astfel de interacțiuni”, explică ea.

În privința riscului de a supraestima capacitatea AI-ului, Nicoleta Danis atrage atenția că este „real și semnificativ”. O performanță impresionantă într-un context, cum ar fi rezolvarea unor probleme de matematică de nivel olimpic, nu garantează rezultate la fel de bune în orice situație. Fără înțelegerea limitărilor, deciziile pot fi greșite, bazate pe o încredere nejustificată.

Întrebată unde ar putea fi util un „matematician” AI rapid, dar fără creativitate, specialista subliniază că, în România, astfel de modele pot fi valoroase în domenii precum analiza financiară, logistică, telecom, energie sau administrație publică, mai precis acolo unde volumul de date este mare și viteza contează mai mult decât intuiția. În toate cazurile, însă, „întotdeauna cu validare umană”, subliniază Nicoleta Danis.

Riscurile unor erori banale nu sunt de neglijat: „În termeni economici sau de siguranță, o eroare aparent minoră poate avea efecte majore. Un calcul greșit într-un sistem de alocare de resurse, într-un proces de achiziție sau într-un algoritm de control industrial poate genera pierderi financiare, blocaje operaționale sau chiar riscuri pentru oameni”, completează aceasta.

În ceea ce privește educația, Nicoleta Danis avertizează asupra pericolului ca elevii să „meargă pe pilot automat”: „Ca părinte, simt direct presiunea pe care o pune tehnologia asupra modului în care copiii învață. Da, există un risc real dacă nu adaptăm procesul didactic. Copiii trebuie să înțeleagă cum funcționează aceste modele, să pună întrebări, să verifice, să gândească critic. Dacă școala nu reușește să țină pasul, părinții trebuie să fie conectați, mai mult ca oricând. Tehnologia nu trebuie să înlocuiască gândirea, ci să o provoace și să o dezvolte,” conchide ea.

AI-ul, aur la Olimpiada Internațională de Matematică

Luna trecută, pentru prima dată în istoria competiției, modele de inteligență artificială au obținut medalii de aur la Olimpiada Internațională de Matematică. OpenAI a anunțat la finele lunii iulie, pe X, că cel mai recent model cu raționament experimental al companiei a atins performanța, iar la câteva ore distanță, Google a transmis un mesaj similar, precizând că un model avansat de-al companiei a rezolvat cinci din cele șase probleme ale testului, rezultat echivalent medaliei de aur.

Reușitele marchează un pas important în dezvoltarea modelelor AI capabile de așa-numit „raționament”, deși unii cercetători avertizează că acest termen nu descrie în mod fidel procesele interne ale tehnologiei. Anul trecut, AI-ul Google obținuse medalia de argint în aceeași competiție, ceea ce subliniază ritmul accelerat al progreselor pe care le fac modele AI.

Performanțele nu sunt lipsite de controverse. Google a pus sub semnul întrebării anunțul OpenAI, acuzând că dezvoltatorul ChatGPT nu a respectat regula de a face publice rezultatele decât după verificarea de către experți independenți. OpenAI a răspuns că nu era la curent cu această cerință și că a apelat la o echipă proprie de specialiști independenți pentru validarea soluțiilor.

Un profesor de matematică de la Universitatea Stanford folosește de un an același exercițiu extrem de dificil (o problemă nerezolvată până acum în domeniul său) pentru a testa limitele fiecărei noi versiuni de AI lansate de OpenAI. La fiecare actualizare, profesorul trimite din nou problema, iar rezultatele primite au fost, până de curând, greșite.

După succesul OpenAI la Olimpiada Internațională de Matematică, situația a luat o turnură neașteptată: ultima versiune a modelului nu a reușit să găsească soluția, dar nici nu a inventat una. În loc să ofere un răspuns fals cu încredere, AI-ul a afișat mesajul „no answer”, recunoscând că nu poate rezolva problema. „Cred că a fost bine să vedem că modelul nu încearcă să halucineze sau să fabrice o soluție, ci spune în schimb «no answer»”, a declarat Noam Brown, cercetător OpenAI, pentru The Decoder.

„Suntem departe de AGI”

Acest experiment accidental arată un tip de progres pe care testele standard îl ratează: modelele încep să fie mai bune în a-și recunoaște propriile limite, în loc să livreze răspunsuri greșite, dar formulate cu siguranță.

O echipă de cercetători din Spania vede o tendință similară în rezultatele mult discutatului studiu Apple despre modelele de raționament. Și acolo, modele precum o3 au întrerupt răspunsurile înainte de a finaliza propunerea vreunei soluții. Dacă pentru Apple acest lucru a fost un simplu eșec, cercetătorii spanioli consideră că este o strategie învățată: AI-ul își dă seama când este blocat și se oprește, mai scrie The Decoder.

Cu toate acestea, avertizează Brown, suntem departe de a fi protejați complet de ceea ce el numește „AI-generated bullshit”. OpenAI plănuiește să pună modelul său olimpic la dispoziția matematicienilor pentru testare, dar îmbunătățirile care au dus la acest comportament nu vor fi implementate în versiunile comerciale timp de câteva luni.

Gary Marcus, profesor american și autor al unui newsletter pe Substack, a comentat performanțele modelelor AI scriind: „Oricine crede că modelele de limbaj de mari dimensiuni sunt o rută directă către un AGI care ar putea transforma fundamental societatea în bine se amăgește singur.”

Prin AGI (Artificial General Intelligence, „inteligență artificială generală”) se înțelege un tip ipotetic de AI capabil să egaleze sau să depășească un om în orice sarcină intelectuală: să înțeleagă concepte din domenii complet diferite, să transfere cunoștințe dintr-un context în altul și să rezolve probleme fără a fi nevoie de reantrenare.

În prezent, sistemele disponibile sunt „specializate” și performează doar în limitele pentru care au fost antrenate, departe de flexibilitatea și adaptabilitatea unui AGI.