Fact Check: Imagini false în războiul dintre Israel şi Hamas

0Războiul din Gaza, dintre Israel și Hamas, este însoțit de falsuri și dezinformări rar întâlnite până acum: imagini generate de inteligența artificială. Cum să le recunoaștem?

Ce sunt falsurile generate cu ajutorul programelor de inteligență artificială (AI), ce povești ilustrează ele și cât de periculoase sunt? Echipa DW Fact Check răspunde la cele mai importante întrebări despre rolul AI în conflictul dintre Israel și Hamas din Gaza.

Cum funcționează falsurile generate de AI?

Inteligența artificială este prezentă acum peste tot - chiar și în războaie. Iar programele care o generează s-au îmbunătățit substanțial în acest an. Aproape oricine poate folosi acum generatoare de AI pentru a crea imagini care par reale, cel puțin la prima vedere.

Pentru a face acest lucru, utilizatorii trebuie să „alimenteze” instrumente precum Midjourney sau Dall-E cu solicitări, adică să le ofere cereri, specificații și informații despre ce așteptări au. Programele computerizate transformă aceste detalii în imagini. Unii utilizatori vor să creeze ilustrații mai artistice, alții își propun să ilustreze situații presupus reale, așa cum fac fotografiile.

Procesul de generare se bazează pe așa-numita învățare automată. Dacă ceri generatoarelor să arate un bărbat de 70 de ani care merge pe bicicletă, acestea vor căuta în bazele lor de date, în care textele sunt asociate cu imagini. În baza informațiilor disponibile acolo, generatorul AI creează imaginea biciclistului mai în vârstă.

Numărul crescut de intrări și îmbunătățirile tehnice au perfecționat asemenea programe foarte mult în ultimii ani și, mai ales, în lunile din urmă - și acestea învață constant tot mai mult.

Se întâmplă așa și în cazul imaginilor despre conflictul din Orientul Mijlociu. Utilizatorii folosesc instrumentele de generat imagini pentru a crea scene cât mai realiste. Conform observațiilor DW, falsurile AI descriu adesea momente tulburătoare, pentru a răspândi anumite ipoteze. În acest conflict, „în care emoțiile sunt foarte, foarte mari”, dezinformarea, inclusiv utilizarea imaginilor AI, funcționează deosebit de bine și sunt terenul ideal pentru amplificarea reacțiilor pasionale, este de părere Hany Farid, profesor de criminalistică digitală la Universitatea Berkeley din California.

Câte imagini AI circulă în războiul Israel - Hamas?

În timpul războiului din Ucraina, imagini și videoclipuri create cu ajutorul inteligenței artificiale au contribuit la dezinformare - și continuă să o facă. Deoarece instrumentele AI s-au dezvoltat recent rapid, mulți observatori se așteptau la o prezență și mai mare a AI în războiul dintre Israel și Hamas. Dar, potrivit experților, marele val de imagini generate de inteligența artificială încă nu s-a întâmplat, până acum.

„Nu vedem o utilizare masivă a imaginilor generate de AI”, spune Tommaso Canetta de la Observatorul European pentru Media Digitală: „Suma este destul de mică, dacă e să o comparăm cu alte forme de dezinformare, cum ar fi imaginile și videoclipurile mai vechi redistribuite acum cu precizarea falsă că ar proveni din zone de conflict activ”. Asta nu înseamnă, însă, că tehnologia nu joacă un rol.

Hany Farid explică, într-un interviu acordat DW, că nu consideră numărul de falsuri AI la o dimensiune relevantă. „Doar două imagini devenite virale, văzute de sute de milioane de oameni, pot fi interpretate că ar fi avut un impact uriaș”. Dar principala reușită a falsurilor AI și a altor forme de dezinformare este că „poluează ecosistemul informațional”.

Cui servesc falsurile AI în războiul Israel - Hamas?

Imaginile AI care circulă pe rețelele de socializare sunt de obicei capabile să declanșeze emoții puternice celor care le văd. Canetta identifică două categorii principale. Sunt, pe de o parte, imaginile care se concentrează asupra suferinței populației civile și trezesc milă față de oamenii aflați în potențiale astfel de situații. Pe de alta, sunt imagini generate artificial care exagerează dramatismul - fie în favoarea Israelului, fie pentru Hamas și pentru palestinieni - cu scopul de a exacerba sentimente patriotice.

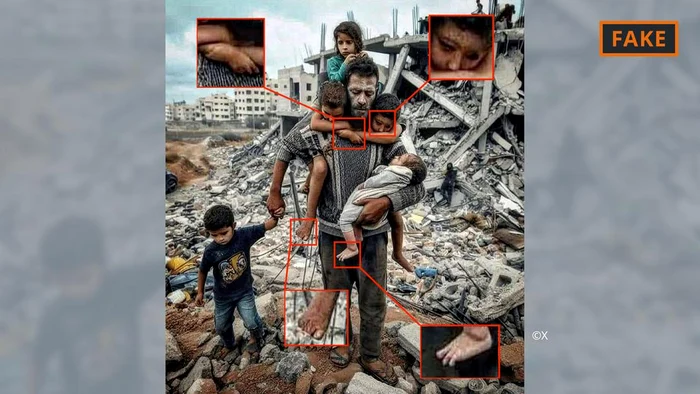

Imaginea de mai sus, care reprezintă un tată cu cei cinci copii ai săi în fața unui munte de moloz, a fost distribuită intens pe rețeaua de socializare X (fostul Twitter) și pe platforma Instagram, cu mențiunea că ar fi o imagine surprinsă în contextul bombardamentelor Israelului asupra Fâșiei Gaza. Dar falsul poate fi, la o privire atentă, ușor recunoscut, pentru că ilustrația conține erori și inconsecvențe (încă) tipice pentru imaginile AI.

Astfel: umărul drept al bărbatului stă disproporționat de sus, cele două membre care ies pe dedesubt sunt ciudate, ca și cum ar crește din pulover; bătătoare la ochi sunt și mâinile celor doi băieți, care și-au înfășurat brațele în jurul gâtului tatălui lor și se unesc; nu în ultimul rând, în imagine există mai multe mâini și picioare, la care, în plus, apar prea multe sau prea puține degete. Până una-alta, ea fost văzută de sute de mii de ori. Între timp, pe X, imaginea a fost marcată cu o notificare prin care se menționează că este falsă.

Anomalii similare pot fi observate și într-un alt fals devenit viral pe X, în care se presupune că o familie palestiniană mănâncă împreună în dărâmături.

În cea de a doua categorie de falsuri regăsim o imagine în care soldați mărșăluind printre ruinele unor clădiri bombardate flutură steaguri israeliene. Conturile care răspândesc imaginea pe Instagram și pe X par în mare parte a fi proisraeliene și salută evenimentul prezentat. DW a descoperit imaginea într-un articol publicat de o publicație online din Bulgaria, care nu a etichetat-o ca fiind generat de inteligența artificială.

Ceea ce pune în evidență în acest caz falsul este felul în care stau steagurile israeliene. În plus, strada pare prea curată pe mijlocul ei, în timp ce molozul arată foarte uniform: impresia vizuală este prea „curată” pentru a părea realistă. O astfel de impecabilitate, care face ca imaginile să pară pictate, este tipică pentru AI.

De unde provin imaginile generate artificial?

Majoritatea imaginilor create cu ajutorul inteligenței artificiale sunt distribuite de conturi private pe rețelele de socializare. Sunt postate atât de profiluri autentice, cât și, evident, de unele false.

Imaginile generate de AI sunt folosite și în jurnalism. Dacă și în ce cazuri acest lucru poate fi util sau etic este un subiect în prezent discutat în multe companii media.

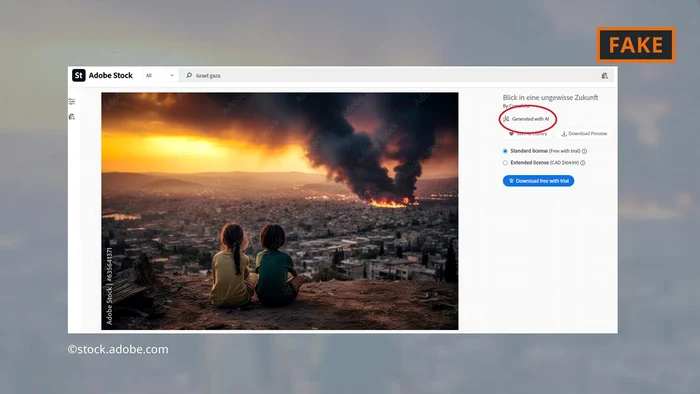

Compania de software Adobe a făcut furori când a adăugat în banca sa de imagini fotografii generate computerizat, la sfârșitul anului 2022. Acestea sunt însă furnizate cu o notă corespunzătoare care specifică originea AI a ilustrațiilor respective.

Între timp, Adobe oferă spre vânzare și imagini produse de AI ale războiului din Orientul Mijlociu - de exemplu, cu explozii, cu oameni care protestează sau cu nori de fum ridicându-se în spatele moscheei Al-Aqsa. Criticii au serioase îndoieli în privința acestor produse.

Unele site-uri online și instituții media au continuat să folosească imaginile generate de AI fără a le eticheta ca atare - DW a aflat acest lucru folosind instrumentele de căutare inversă a traseului imaginilor, utilizate, între altele, pentru aflarea surselor unor ilustrații.

Și Serviciul de Cercetare al Parlamentului European, care se ocupă de analize științifice pentru forul comunitar, ilustrează un text online despre conflictul din Orientul Mijlociu cu una dintre pseudo fotografiile achiziționate din baza de date Adobe – tot fără a semnala că este o imagine generată de AI.

Tommaso Canetta, de la Observatorul European pentru Media Digitală, face apel la profesioniştii mass-media să fie foarte atenţi cu modul în care pun în circulație imaginile AI. Îi sfătuiește să nu o facă, mai ales când vine vorba de evenimente în derulare, cum ar fi războiul din Orientul Mijlociu. Lucrurile stau altfel, desigur, când este nevoie de ilustrarea unor subiecte abstracte, cum ar fi viitorul tehnologiei.

Câte daune provoacă imaginile AI?

Consumatorii media știu că în spațiul public circulă conținut generat de AI iar asta îi face să devină nesiguri cu privire la tot ceea ce întâlnesc în online. Cercetătorul de la Berkeley Farid explică: „Abilitatea de a manipula imagini dar și materiale audio și video duce la repunerea în discuție a tuturor lucrurilor”.

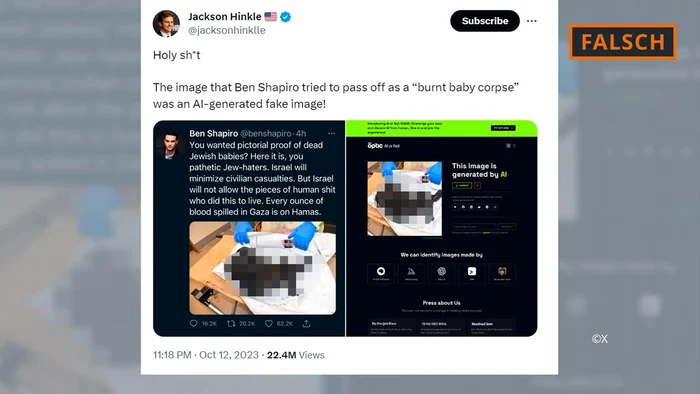

Uneori se întâmplă ca imaginile reale să fie incorect marcate ca neautentice. O imagine despre care se spune că ar prezenta cadavrul carbonizat al unui copil israelian a fost distribuită pe X printre alții de prim-ministrul israelian Benjamin Netanyahu și de comentatorul conservator american Ben Shapiro. Influencerul antiisraelian Jackson Hinkle a susținut apoi că imaginea ar fi fost creată folosind inteligența artificială.

Pentru a-și argumenta afirmația, Hinkle a atașat la postarea sa captura de ecran a detectorului de ilustrații artificiale „AI sau nu”, care a clasificat imaginea ca fiind generată computerizat. Postarea lui Hinkle de pe rețeaua X a fost văzută de peste 20 de milioane de ori și a stârnit dezbateri aprinse acolo.

În cele din urmă, mulți au ajuns la concluzia că imaginea era cel mai probabil reală și că Hinkle a greșit. Chiar și Hany Farid a precizat pentru DW că nu a găsit nicio discrepanță în imagine, care să indice un fals AI.

Detectoarele care pot fi utilizate pentru a verifica dacă o imagine sau un text au fost sau nu generate de AI sunt încă predispuse la scăpări. În funcție de imaginea examinată, acestea fac judecăți aproximative care de multe ori vin însoțite de o declarație de probabilitate „sub 100%”. De aceea sunt de fapt doar instrument suplimentar, în nici un caz nu singurul, de verificare a falsurilor AI.

Nici echipa DW de verificare a informațiilor nu poate găsi vreun semn clar de manipulare realizată de inteligența artificială în imaginea care arată cel mai probabil cadavrul unui copil. Aceeași aplicație „AI sau nu”, invocată și de Hinkle, folosită acum de DW, nu a clasificat aceeași imagine ca fiind generată computerizat și asta din cauza calității slabe a imaginii. Autenticitatea fotografiei a fost probată de DW folosind și un alt detector de imagini computerizate, Hive moderation.