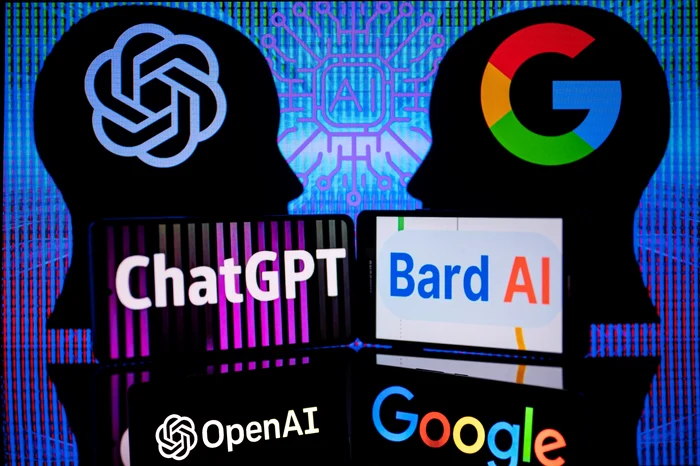

Care sunt riscurile de confidențialitate și securitate pentru companiile care folosesc ChatGPT și Bard

0În vederea unei utilizări eficiente a modelelor lingvistice de mari dimensiuni (LLM), companiile trebuie să poată gestiona riscurile ce ar putea influența valoarea comercială a acestei tehnologii, scrie Phil Muncaster, jurnalist IT, pe blogul ESET.

ChatGPT, Bard și inteligența artificială generativă sunt subiecte de discuție pentru toată lumea. Cu toate acestea, după ce entuziasmul inițial se diminuează, realitatea își face apariția. Liderii din domeniile afacerilor și IT sunt fascinați de potențialul disruptiv al tehnologiei în domenii precum asistența clienților și dezvoltarea de software, dar își dau seama tot mai mult de dezavantajele și riscurile care vin odată cu această evoluție.

Pe scurt, pentru ca organizațiile să exploateze în siguranță potențialul LLM-urilor, acestea trebuie să fie capabile să gestioneze și riscurile ascunse care, în caz contrar, ar putea afecta percepția asupra tehnologiei.

Ce înseamnă LLM?

ChatGPT și alte instrumente de inteligență artificială generativă sunt alimentate de LLM-uri. Acestea funcționează prin utilizarea rețelelor neuronale artificiale pentru a procesa cantități enorme de date în format text. După ce învață legăturile dintre cuvinte și modul în care acestea sunt utilizate în context, modelul este capabil să interacționeze în limbaj natural cu utilizatorii. De fapt, unul dintre principalele motive ale succesului remarcabil al ChatGPT este capacitatea sa de a spune glume, de a compune poezii și, în general, de a comunica într-un mod greu de diferențiat de ce cel utilizat de către un om adevărat.

Modelele de inteligență artificială generativă LLM, așa cum sunt utilizate în roboții de chat, cum ar fi ChatGPT, funcționează ca niște motoare de căutare supraalimentate, folosind datele folosite pentru instructaj pentru a răspunde întrebărilor și a îndeplini sarcinile cu un limbaj asemănător celui uman. Indiferent dacă sunt modele disponibile public sau modele proprietare utilizate intern într-o organizație, AI generativă bazată pe LLM poate expune companiile la anumite riscuri de securitate și confidențialitate.

Top 5 riscuri asociate folosirii LLM

1. Partajarea excesivă a datelor sensibile

Chatboturile bazate pe LLM nu se pricep să păstreze secrete - sau să le uite, de altfel. Asta înseamnă că orice date pe care le introduceți pot fi integrate în model și puse la dispoziția altora sau cel puțin folosite pentru a antrena viitoarele modele LLM. Angajații Samsung au aflat acest lucru atunci când au împărtășit informații confidențiale cu ChatGPT în timp ce îl foloseau pentru sarcini legate de muncă. Codul și înregistrările ședințelor pe care le-au introdus în instrument ar putea fi, teoretic, disponibile publicului (sau cel puțin stocate pentru o utilizare viitoare, după cum a subliniat recent Centrul Național de Securitate Cibernetică din Regatul Unit). La începutul acestui an, am analizat mai îndeaproape modul în care organizațiile pot evita să-și pună datele în pericol atunci când utilizează LLM-uri.

2. Provocări legate de drepturile de autor

LLM-urile sunt antrenate pe cantități mari de date. Dar aceste informații sunt adesea extrase de pe internet, fără permisiunea explicită a proprietarului conținutului. Acest lucru poate crea potențiale probleme legate de drepturile de autor dacă veți continua să le folosiți. Cu toate acestea, poate fi dificil de găsit sursa originală a datelor specifice utilizate în instruirea modelului, ceea ce face dificilă atenuarea acestor probleme.

3. Cod nesigur

Dezvoltatorii apelează din ce în ce mai mult la ChatGPT și la instrumente similare pentru a-i ajuta să accelereze timpul de lansare pe piață a software-ului sau a aplicației. În teorie, acesta poate ajuta prin generarea rapidă și eficientă de fragmente de cod și chiar de programe software întregi. Cu toate acestea, experții în securitate avertizează că poate genera, de asemenea, vulnerabilități. Acest lucru este o preocupare sensibilă dacă dezvoltatorul nu are suficiente cunoștințe tehnice astfel încât să știe ce bug-uri să caute și să identifice. În cazul în care codul plin de bug-uri trece ulterior în etapa de producție, acesta ar putea avea un impact serios asupra reputației și ar putea necesita timp și bani pentru a fi corectat.

4. Compromiterea modelului în sine

Accesul neautorizat și compromiterea LLM-urilor ar putea oferi hackerilor o serie de opțiuni pentru a derula activități rău intenționate, cum ar fi determinarea modelului să divulge informații sensibile prin atacuri de tipul prompt injection sau să efectueze alte acțiuni care ar trebui să fie blocate. Alte atacuri pot implica exploatarea vulnerabilităților SSRF (server-side request forgery) din serverele LLM, permițând atacatorilor să extragă resurse interne. Actorii de amenințări ar putea chiar găsi o modalitate de a interacționa cu sisteme și resurse confidențiale prin simpla transmitere de comenzi rău intenționate prin intermediul prompt-urilor.

Spre exemplu, ChatGPT a trebuit să fie pus offline în luna martie, în urma descoperirii unei vulnerabilități care a expus unor utilizatori subiectele din istoricul conversațiilor altor utilizatori. Pentru a crește gradul de conștientizare al vulnerabilităților din aplicațiile LLM, Fundația OWASP a publicat recent o listă cu 10 lacune de securitate critice observate frecvent în aceste aplicații.

5. O breșă de securitate a datelor suferită de furnizorul de AI

Întotdeauna există posibilitatea ca o companie care dezvoltă modele de inteligență artificială să fie ea însăși compromisă, permițând hackerilor să sustragă, de exemplu, datele folosite pentru instruire care ar putea include informații sensibile de proprietate. Același lucru este valabil și în cazul scurgerilor de date, cum a fost cazul în care Google a expus din greșeală chat-uri private ale Bard în rezultatele sale de căutare.

Ce este de făcut în continuare

Dacă compania dumneavoastră dorește să înceapă să valorifice potențialul inteligenței artificiale generative pentru a obține un avantaj competitiv, există câteva lucruri pe care ar trebui să le puneți în practică mai întâi pentru a atenua unele dintre aceste riscuri:

- Criptarea și anonimizarea datelor: Criptați datele înainte de a le partaja cu LLM pentru a le proteja și luați în considerare tehnici de anonimizare pentru a proteja confidențialitatea persoanelor care ar putea fi identificate în seturile de date. Filtrarea datelor poate atinge același scop prin eliminarea detaliilor sensibile din datele folosite pentru instruire înainte ca acestea să fie introduse în model.

- Controale de acces îmbunătățite: Parolele puternice, autentificarea cu mai mulți factori (MFA) și politicile de acces vor contribui la asigurarea faptului că numai persoanele autorizate au acces la modelul generativ de inteligență artificială și la sistemele back-end.

- Audituri de securitate regulate: Acestea pot ajuta la descoperirea vulnerabilităților din sistemele dumneavoastră IT care pot avea impact asupra LLM și a modelelor generative AI pe care se bazează.

- Testați planurile de răspuns la incidente: Un plan bine exersat și solid va ajuta organizația dumneavoastră să reacționeze rapid pentru a limita și a ajuta la remedierea și recuperarea în urma oricărei breșe.

- Examinați cu atenție furnizorii de LLM: La fel ca pentru orice alt furnizor, este important să vă asigurați că firma care furnizează LLM respectă cele mai bune practici din industrie în ceea ce privește securitatea și confidențialitatea datelor. Asigurați-vă că există informații clare cu privire la locul în care sunt procesate și stocate datele utilizatorilor și dacă acestea sunt folosite pentru a instrui modelul. Cât timp sunt păstrate? Sunt partajate cu furnizori terți? Puteți oferi acceptul pentru sau vă puteți retrage acest accept ca datele dumneavoastră să fie utilizate pentru instruirea modelului?

- Asigurați-vă că dezvoltatorii respectă liniile directoare stricte privind securitatea: Dacă dezvoltatorii dumneavoastră folosesc LLM-uri pentru a genera cod, asigurați-vă că aceștia respectă politicile în vigoare, cum ar fi testarea securității și revizuirea de tip „inter pares”, pentru a reduce riscul ca bug-urile să se strecoare în etapa de producție.

Vestea bună este că cele mai multe dintre cele de mai sus sunt sfaturi de securitate și bune practici, testate și verificate de-a lungul timpului. Este posibil ca acestea să necesite o actualizare/modificare pentru a acoperi specificitățile lumii inteligenței artificiale, dar principiile de bază ar trebui să fie deja cunoscute de majoritatea echipelor de securitate.